Claude Code vs OpenCode: Welches Agentic CLI passt zu Ihrem Workflow?

Wenn Sie schon länger mit KI in der Softwareentwicklung arbeiten, wissen Sie: Der echte Produktivitätssprung kommt nicht vom "Chatten über Code". Er

2026 sind „Tech-Trends“ weniger eine Frage von glänzenden Produktlaunches – sondern viel mehr die Kräfte, die den IT-Alltag formen: wie Software gebaut wird, wie Systeme sicher bleiben, wie Identitäten verwaltet werden und wie viel Rechenleistung eine Organisation realistisch tragen kann.

Ein hilfreicher Blick auf das Jahr ist, Neuheit von Druck zu trennen. Neuheit ist interessant. Und Druck ist das, was Prioritäten, Budgets und Rollenbilder tatsächlich verschiebt.

In diesem Blog geht es um die Trends, die quer durch die IT relevant sind - Security, Software Engineering, Betrieb und Compliance, übersetzt in das, was sie für Teams bedeuten, die verlässlich liefern müssen.

AI-unterstützte Entwicklung ist keine Neuheit mehr. Sie ist ein Durchsatz-Multiplikator. Der Trade-off ist aber nicht einfach „Qualität wird schlechter“ - sondern: Fehlerbilder verändern sich.

Wenn Teams mit AI-Hilfe schneller shippen, reduzieren sie oft kleine Patzer, erhöhen aber gleichzeitig die Wahrscheinlichkeit tieferliegender Probleme: inkonsistent umgesetzte Berechtigungsgrenzen, fragile Architekturen, subtile Auth-Bugs und „funktioniert in der Demo“-Integrationen, die unter echter Last nicht halten.

Für IT verschiebt sich damit der Schwerpunkt: Der Engpass wandert vom Tippen zur Urteilsfähigkeit. Architektur-Review, Security-Review, Test-Design und Production-Readiness werden zu den knappen Skills.

Man sollte AI-generierten Code wie Code von einer sehr schnellen Junior-Engineer behandeln: nützlich, aber nur mit klaren Guardrails. Standardisierte Reviews, Least Privilege als Default und Investitionen in Tests, die systemisches Verhalten abdecken und nicht nur Happy-Path-Korrektheit, sind wichtig.

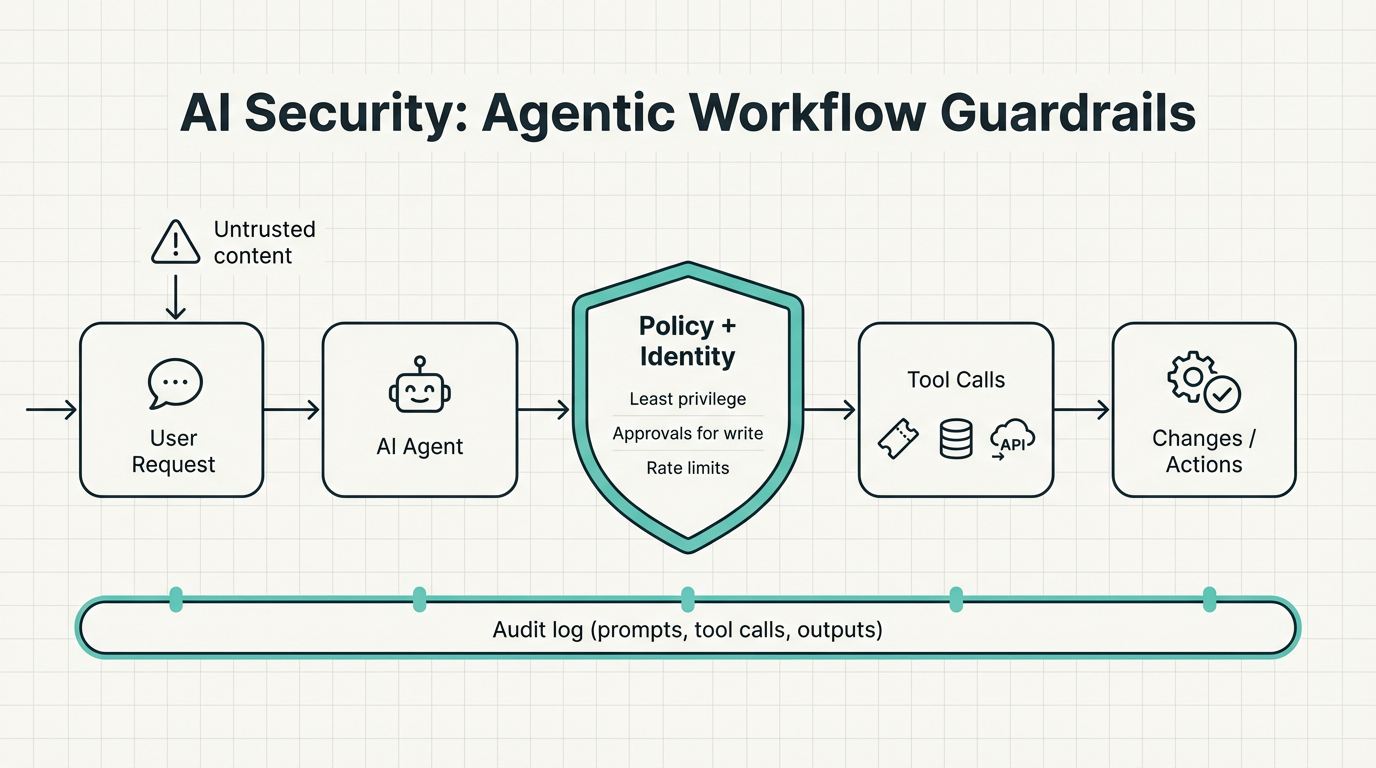

Die wichtigste Security-Story 2026 dreht sich nicht nur um Prompt Injection oder Halluzinationen. Sie dreht sich um AI-Systeme, die handeln (Agents).

Sobald ein Assistent Tickets anlegen, interne Tools abfragen, Configs ändern oder Workflows triggern kann, „nutzt“ man nicht mehr nur AI – man hat eine neue Art Operator in der Umgebung geschaffen. Dieser Operator braucht Identität, Berechtigungen, Logging und klare Grenzen.

Die sicherste Haltung ist bewusst langweilig gedacht: Lesezugriff einfach machen, Schreibzugriff als privilegiert behandeln und Berechtigungen so eng schneiden, wie man es bei einem Service Account tun würde. Ebenso interessant sind Logging von Prompts, Tool-Calls und Outputs Ende-zu-Ende für Auditierbarkeit und ein System-Design unter der Annahme, dass untrusted Content das System erreichen wird – weil er es wird. Möchte man in AI-Security-Tooling investieren, lohnt sich ein Blick in unseren Stack für Agentic AI Engineering und Agentic AI Vulnerability Management an – damit kann man AI-Agents praxisnah bauen und absichern.

Ein wachsender Teil von IT-Strategie wird durch etwas begrenzt, das Teams nicht direkt kontrollieren: die Verfügbarkeit von moderner Rechenleistung. Die Supply Chain ist konzentriert, Lead Times können lang sein, und Nachfrage-Spitzen richten sich selten höflich nach eurer Roadmap.

Das gilt auch dann, wenn man „einfach die Cloud nutzt“. Verfügbarkeit und Preise schlagen downstream durch – in Architekturentscheidungen, Vendor-Auswahl und in das, was Product-Teams überhaupt für machbar halten.

Die praktische Konsequenz heißt Resilienz: Man sollte die Fähigkeit, zu pivotieren, behalten - zwischen Providern, zwischen Modellgrößen und zwischen Deployment-Patterns - damit man nicht an Annahmen klebt, die bei Kapazitäts- oder Preisverschiebungen brechen.

AI ist nicht „nur Software“. Wenn Organisationen AI-Nutzung skalieren, skalieren sie auch Strombedarf – und diese Realität beginnt zu beeinflussen, was möglich ist, was es kostet und wie schnell es ausgerollt werden kann. Ein sichtbares Signal: Kernenergie rückt in mehreren Regionen wieder auf die Roadmap, weil die Nachfrage steigt – mit Laufzeitverlängerungen bestehender Reaktoren, Plänen für Neubauten und beschleunigtem Interesse an Small Modular Reactors als Quelle für stabile, CO2-arme Grundlast.

Die meisten Unternehmen spüren das nicht als Facilities-Thema. Sie spüren es als Zweit- und Drittauswirkungen im Markt: Cloud-Preise und -Verfügbarkeit, langsamere Timelines für Kapazitätsausbau in bestimmten Regionen, Hardware-Lead-Times und häufiger die Executive-Frage „Was bekommen wir für diese Ausgaben?“.

Der sinnvollste Blick ist, Energie als strategische Restriktion zu behandeln, die Roadmaps formen kann. Man kann mit mehr Druck rechnen, rechenintensive Initiativen zu begründen – und mit mehr Aufmerksamkeit für Workloads, die Kosten skalieren, ohne klaren Business Outcome.

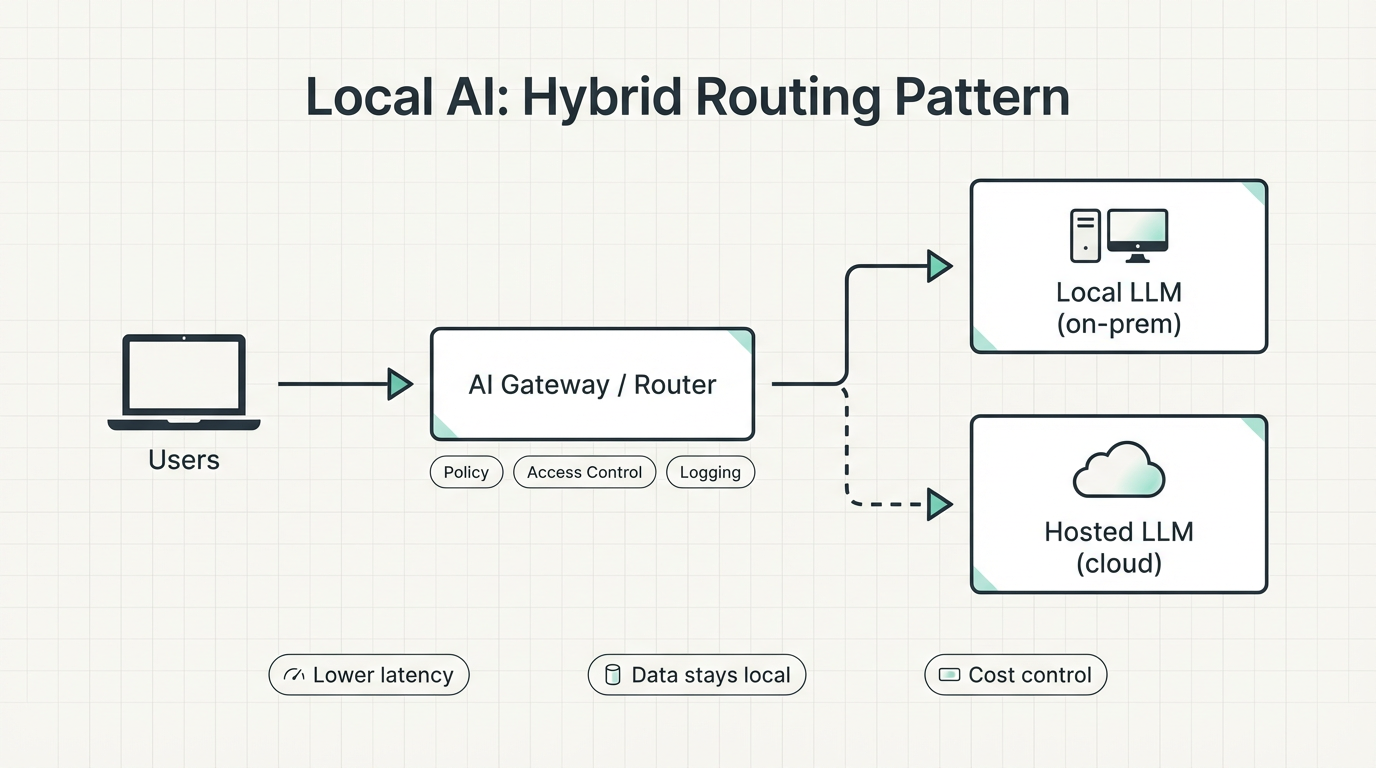

Diese Compute- und Energie-Constraints sind ein Grund, warum Local AI wieder stärker diskutiert wird. Für viele IT-Teams heißt „AI-Adoption“ heute vor allem: mehr Daten und mehr Queries an externe Services schicken – und hoffen, dass Rechnung, Latenz und Compliance-Fragen beherrschbar bleiben.

Lokale LLMs sind kein Zaubertrick, und sie werden Frontier-Cloud-Modelle wohl nicht für jeden Use Case ersetzen. Aber sie sind zunehmend „gut genug“ für viele Alltagsworkflows: Drafting, Zusammenfassen, Klassifizieren, Coding Assistance, leichtes internes Q&A und private Copilots für wiederholbare Aufgaben. Das Wertversprechen ist simpel: Daten bleiben in der eigenen Umgebung, Latenz wird oft berechenbarer, und Kosten lassen sich bei wachsender Nutzung besser steuern.

Die praktische Frage lautet: Wo betreiben wir das? Für viele Organisationen ist die Antwort nicht automatisch ein extrem teures Server-Rack - sondern eine kleine, always-on Maschine im Office oder im Lab. Je praktikabler Local AI wird, desto öfter taucht hier der Mac mini als naheliegende Wahl auf. Er ist günstig genug, um ihn zu rechtfertigen, klein genug, um ihn „vergessen“ zu können, und effizient genug, um ihn laufen zu lassen, ohne dass daraus gleich ein Infrastrukturprojekt wird. Apple-Silicon-Systeme (mit Unified Memory, geringer Leistungsaufnahme, wenig Lärm und starker Performance pro Watt) sind bequeme Boxen, um kleine bis mittlere lokale Modelle sowie Embeddings zu betreiben. Tools wie Ollama oder LM Studio machen den Einstieg einfach. Sie ersetzen keine großen GPU-Server - aber als Startpunkt für Pilots und internes Tooling können sie überraschend effektiv sein.

Wenn man Local AI erkundet, sollte man es wie jede andere IT-Fähigkeit behandeln: Erwartungen setzen, unterstützte Use Cases definieren und ehrlich über Trade-offs sprechen. Dadurch gewinnt man Privacy und Kontrolle, übernimmt aber auch operative Verantwortung – Updates, Modellauswahl, Zugriffskontrolle und Evaluation. Das robusteste Muster ist hybrid: lokal als Default für Routinearbeit, und nur dann zu einem Hosted Model routen, wenn die Aufgabe es wirklich braucht. Schaut euch dazu auch unseren aktuellen Blogpost über Ollama’s 2025 Updates für mehr Details zu Local AI-Optionen an.

Quantencomputing ist für die meisten IT-Teams 2026 weniger eine unmittelbare Technologieentscheidung als ein Thema für Plattformstrategie und Erwartungsmanagement. Der Fortschritt ist real, aber ungleichmäßig: Es gibt sichtbare Durchbrüche und einen geopolitisch getriebenen Wettlauf um Talent, Forschung, Standards und industrielle Anwendungen. Das prägt, welche Anbieter sich durchsetzen, wo Ökosysteme entstehen und wie schnell bestimmte Branchen Zugriff auf Fähigkeiten bekommen, die heute noch experimentell wirken.

Praktisch wird Quantum zuerst nicht als „neues Rechenzentrum“, sondern als spezialisierter Baustein auftauchen, meist über Cloud-Services und hybride Ansätze. Relevanz entsteht dort, wo klassische Systeme an Grenzen stoßen: komplexe KI-Systeme und Agenten, AGI, Simulationen, bestimmte Such- und Sampling-Probleme oder Spezialfälle in Forschung und Industrie. Für IT heißt das: vorbereitet sein, Behauptungen einordnen zu können. Eine sinnvolle Haltung ist, intern Know-how aufzubauen, mögliche Kandidaten-Workloads zu identifizieren und das Thema als Beobachtungs- und Evaluationspunkt auf der Roadmap zu führen – damit man handlungsfähig ist, sobald es in den Stack „als Service“ hereinrutscht.

Am Ende laufen all diese Trends auf eine einfache Realität hinaus: AI wird nicht „ein weiteres Tool“, sondern eine neue Schicht in euren täglichen Arbeitsabläufen – und damit ein Produktivitätshebel und ein Risiko zugleich. Wer 2026 vorne sein will, setzt nicht nur auf mehr Modelle und Tools, sondern auf sauberes Engineering: AI Coding, das Teams messbar schneller macht, AI Security, die Agenten, Systeme und Automationen kontrollierbar hält, Workflow Automation, die Prozesse zuverlässig skaliert, und Local AI, wo Datenschutz, Kosten und Latenz echte Vorteile bringen. Wenn man diese Themen nicht als Einzelinitiativen, sondern als zusammenhängende Architektur denkt, entstehen daraus robuste Systeme statt kurzfristiger Demos – und genau dabei können wir unterstützen. Wenn ihr aus diesen Themen etwas machen wollt, das in Produktion funktioniert – nicht nur auf Slides – dann helfen wir von Infralovers gerne dabei, AI Coding, AI Security, Workflow Automation und Local AI so zu planen, umzusetzen und abzusichern, dass es zu eurer Realität passt und mitwächst.

Sie interessieren sich für unsere Trainings oder haben einfach eine Frage, die beantwortet werden muss? Sie können uns jederzeit kontaktieren! Wir werden unser Bestes tun, um alle Ihre Fragen zu beantworten.

Hier kontaktieren