Dark Factory Gap: Was passiert mit Teams, Rollen und Organisationen

In Teil 1 dieser Serie haben wir das Warum durchgearbeitet: Shapiros fünf Stufen der KI-Entwicklung, Brynjolfssons J-Kurve, und die Kernthese, dass AI-Tools

Erinnern Sie sich noch an letzten Juli, als wir uns mit Ollama und seinem Versprechen für lokale KI beschäftigt haben? Seitdem ist viel passiert. Ollama hat einige ziemlich bedeutende Updates veröffentlicht, die zeigen, dass sie sich nicht mehr nur auf die Befehlszeile beschränken – obwohl sie ihre Wurzeln auch nicht vergessen haben.

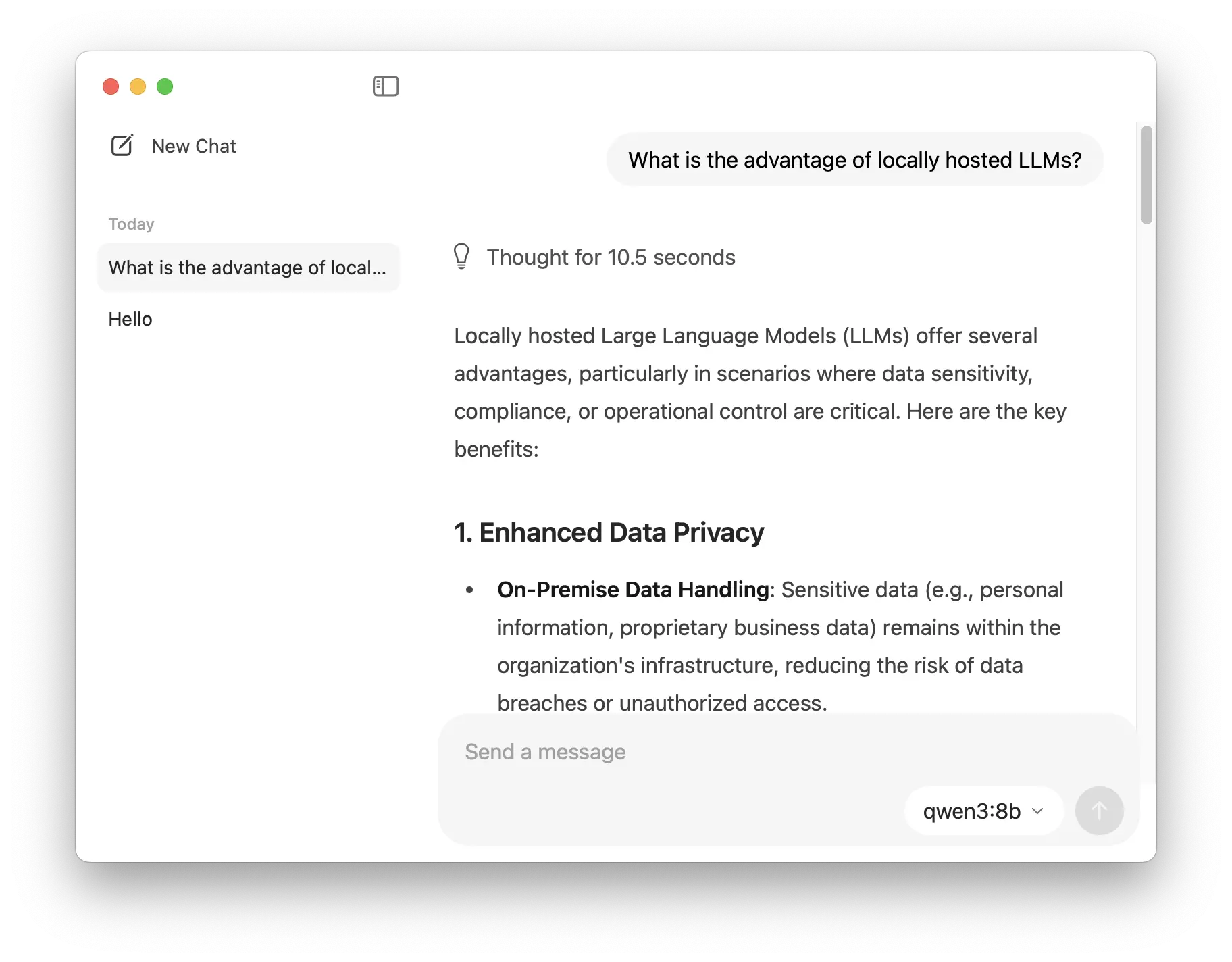

Ollama hat am 30. Juli 2025 eine native Desktop-Anwendung für macOS und Windows eingeführt und damit einen wichtigen Schritt in Richtung Benutzerfreundlichkeit gemacht, da das Tool nun für ein breiteres Publikum zugänglich ist. Die Benutzeroberfläche ist übersichtlich und unkompliziert und konzentriert sich auf wesentliche Funktionen wie ein Chat-Fenster und den Verlauf der Interaktionen, ohne viel Komplexität. Benutzer können PDFs oder Bilder einfach per Drag & Drop in das Chat-Fenster ziehen, um eine nahtlose Modellinteraktion zu ermöglichen, sofern das Modell dies unterstützt. In der neuen Benutzeroberfläche wurden auch einige Einstellungen eingeführt. Beispielsweise ermöglicht ein neuer Schieberegler für die Kontextlänge eine präzise Steuerung darüber, wie viele Informationen das Modell speichert, was sich bei längeren Sitzungen als sehr nützlich erweist.

Ollama hat im August dieses Jahres Turbo als Vorschauversion eingeführt – einen Cloud-Inferenzdienst zum Preis von 20 US-Dollar pro Monat. Dies stellt eine Veränderung für eine Plattform dar, die ursprünglich auf die lokale KI-Bereitstellung ausgerichtet war. Turbo bietet Zugriff auf Hardware in Rechenzentrumsqualität für die Ausführung größerer Modelle, die auf typischer Verbraucherhardware nicht praktikabel wären.

Die Ankündigung hat gemischte Reaktionen hervorgerufen. Während einige die Option für eine verbesserte Leistung begrüßen, fragen sich andere, ob dies mit Ollamas „Local-First“-Philosophie vereinbar ist. Mit einem Preis von 20 US-Dollar pro Monat steht der Dienst in Konkurrenz zu etablierten Cloud-Anbietern wie Anthropic Claude und OpenAI, die ihre proprietären Modelle zu ähnlichen Preisen anbieten.

Wichtiger Hinweis: Die lokale Ollama-Funktionalität bleibt vollständig kostenlos und erfordert kein Konto. Man kann Modelle lokal herunterladen, ausführen und verwalten, ohne sich registrieren oder anmelden zu müssen. Das Kontosystem wird erst relevant, wenn man auf Cloud-basierte Funktionen wie Turbo zugreifen möchte.

Es gab auch weitere API-Verbesserungen, die Entwickler beachten sollten:

Das im Juni 2025 gemeinsam mit dem Hazy Research Lab der Stanford University vorgestellte Secure Minions ermöglicht es lokalen Ollama-Modellen, mit leistungsstärkeren Cloud-Modellen zusammenzuarbeiten, während alle Daten durchgehend verschlüsselt bleiben. Es läuft auf NVIDIA H100-GPUs im vertraulichen Rechenmodus und liefert bis zu 98 % der Genauigkeit von Spitzenmodellen bei 5- bis 30-mal geringeren Kosten und weniger als 1% zusätzlicher Latenz – so wird sichergestellt, dass sensible Daten niemals im Klartext das Gerät verlassen.

Mehrere Optimierungsupdates verbessern die Leistung und Benutzerfreundlichkeit:

Die Updates für 2025 zeigen die Entwicklung von Ollama von einem einfachen lokalen Modell-Runner zu einer robusten KI-Plattform, die sowohl lokale als auch cloudbasierte Optionen bietet. Während die Einführung kostenpflichtiger Dienste wie Turbo eine Debatte ausgelöst hat, legt Ollama weiterhin den Schwerpunkt auf kostenlose, quelloffene lokale Funktionen, um die Zugänglichkeit für datenschutzbewusste und kostenbewusste Nutzer zu gewährleisten. Mit Blick auf die Zukunft hat das Team neue Funktionen angedeutet, die die Desktop-Integration weiter verbessern werden, darunter ein Update des Computer-Use-Agenten für eine nahtlose Interaktion mit lokalen Dateien und Anwendungen – ähnlich wie bei aktuellen Tools wie dem Desktop-Agenten von Claude.

Dieser neue hybride Ansatz positioniert Ollama so, dass es sowohl einzelne Entwickler, die lokale KI-Funktionen suchen, als auch Unternehmen, die open-source skalierbare, leistungsstarke Inferenz benötigen, bedienen kann – obwohl der langfristige Erfolg dieser Strategie von wettbewerbsfähigen Preisen, der Verfügbarkeit von Modellen und kontinuierlichen Investitionen in lokale Funktionen abhängt.

Wir alle wissen, dass KI ein nie endender Prozess der Verbesserung und Anpassung ist und es oft schwierig ist, mit den neuesten Entwicklungen Schritt zu halten. Wir bei Infralovers möchten dabei helfen, sich in dieser Landschaft zurechtzufinden. Abonnieren Sie unseren Newsletter, um die neuesten Updates und Einblicke zu erhalten!

Sie interessieren sich für unsere Trainings oder haben einfach eine Frage, die beantwortet werden muss? Sie können uns jederzeit kontaktieren! Wir werden unser Bestes tun, um alle Ihre Fragen zu beantworten.

Hier kontaktieren